라마클라우드

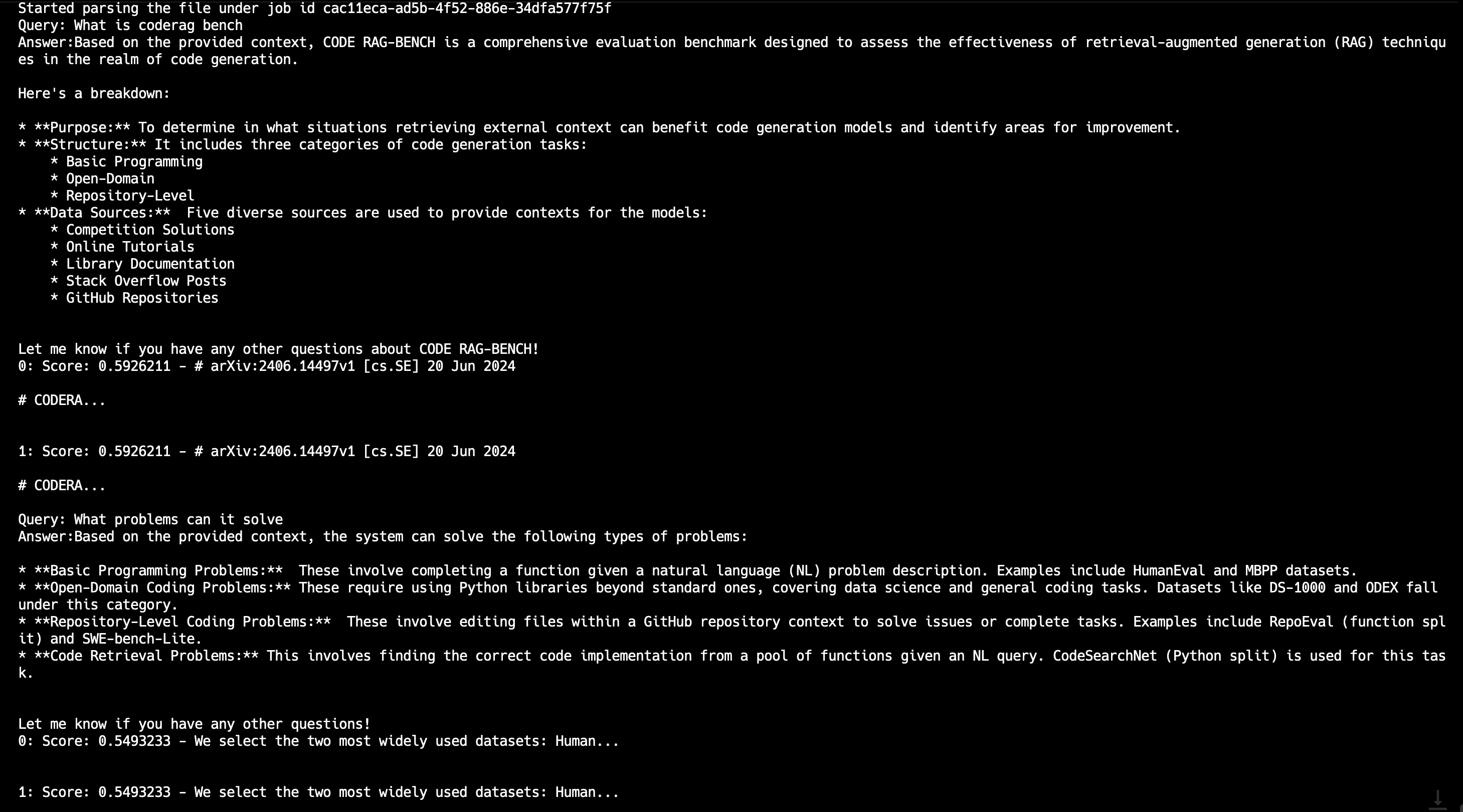

LlamaParse는 파일을 효율적으로 구문 분석하고 표현하여 효율적인 검색 및 컨텍스트 증강을 위해 LlamaIndex 프레임워크를 사용하여 만든 API입니다. LlamaParse는 pdf, doc, .ppt 및 기타 형식과 같은 다양한 종류의 파일을 지원할 수 있습니다.

Gaia 노드를 LLM 백엔드로 사용하도록 LlamaParse를 구성할 수 있으므로 로컬에서 PDF 파일을 기반으로 RAG 애플리케이션을 만들 수 있습니다.

전제 조건

공개 URL을 통해 LLM 서비스를 제공하려면 Gaia 노드가 준비되어 있어야 합니다. 다음을 수행할 수 있습니다.

이 튜토리얼에서는 퍼블릭 노드를 사용하여 계속 플러그인을 구동합니다.

| 모델 유형 | API 기본 URL | 모델명 |

|---|---|---|

| 잡담 | https://llama8b.gaia.domains/v1 | llama |

| 포함 | https://llama8b.gaia.domains/v1 | 노믹 임베드 |

단계

오픈 소스 GitHub 리포지토리를 사용할 것입니다. 라마파스 통합를 사용하여 라마페이스를 쉽게 사용할 수 있습니다. 그리고 라마파스 통합 애플리케이션 지원

- 다음과 같은 여러 파일 형식

.pdf그리고.doc, - 여러 파일

먼저 터미널에서 소스 코드를 가져와야 합니다.

git clone https://github.com/alabulei1/llamaparse-integration.git

CD 라마파스-통합

다음으로 필요한 모드 패키지를 설치합니다.

npm 설치 llamaindex

npm 설치 dotenv

Qdrant 인스턴스를 시작합니다. Qdrant 인스턴스는 임베딩을 저장하기 위한 것입니다.

mkdir qdrant_storage

mkdir qdrant_snapshots

nohup docker run -d -p 6333:6333 -p 6334:6334 \.

-v $(pwd)/qdrant_storage:/qdrant/storage:z \.

-v $(pwd)/qdrant_snapshots:/qdrant/snapshots:z \ \.

qdrant/qdrant

그런 다음 LLM 모델 설정을 설정해야 합니다. 모델 설정은 .env 파일을 만듭니다.

OPENAI_BASE_URL=https://llama8b.gaia.domains/v1/

OPENAI_API_KEY=gaianet

LLAMAEDGE_CHAT_MODEL=llama

LLAMAEDGE_EMBEDDING_MODEL=nomic

LLAMA_CLOUD_API_KEY=Your_Own_KEY

FILE_PATH=

FILE_DIR=./pdf_dir

COLLECTION_NAME=기본값

QDRANT_URL=http://127.0.0.1:6333

SAVE_MARKDOWN_PATH=output.md

다음은 몇 가지 참고 사항입니다. .env 설정:

- LlamaCloud 키는 https://cloud.llamaindex.ai 에서 받을 수 있습니다.

- 모델 설정 및 파일 경로에 따라 변경해야 할 수도 있습니다.

- 파일 이름을

FILE_PATH=를 클릭하면 프로그램이 이 단일 PDF 파일로 RAG 애플리케이션을 빌드합니다. - 만약

FILE_PATH=가 비어 있으면 프로그램은 아래의 파일로 RAG 응용 프로그램을 빌드합니다.FILE_DIR=./pdf_dir. 폴더에 여러 파일을 포함할 수 있습니다.

다음으로, 프로그램을 실행하여 PDF 파일을 기반으로 RAG 애플리케이션을 빌드할 수 있습니다.

npx tsx pdfRender.ts

성공적으로 실행되면 명령줄을 통해 쿼리를 보낼 수 있습니다.